完美岛ai推荐:

基本信息

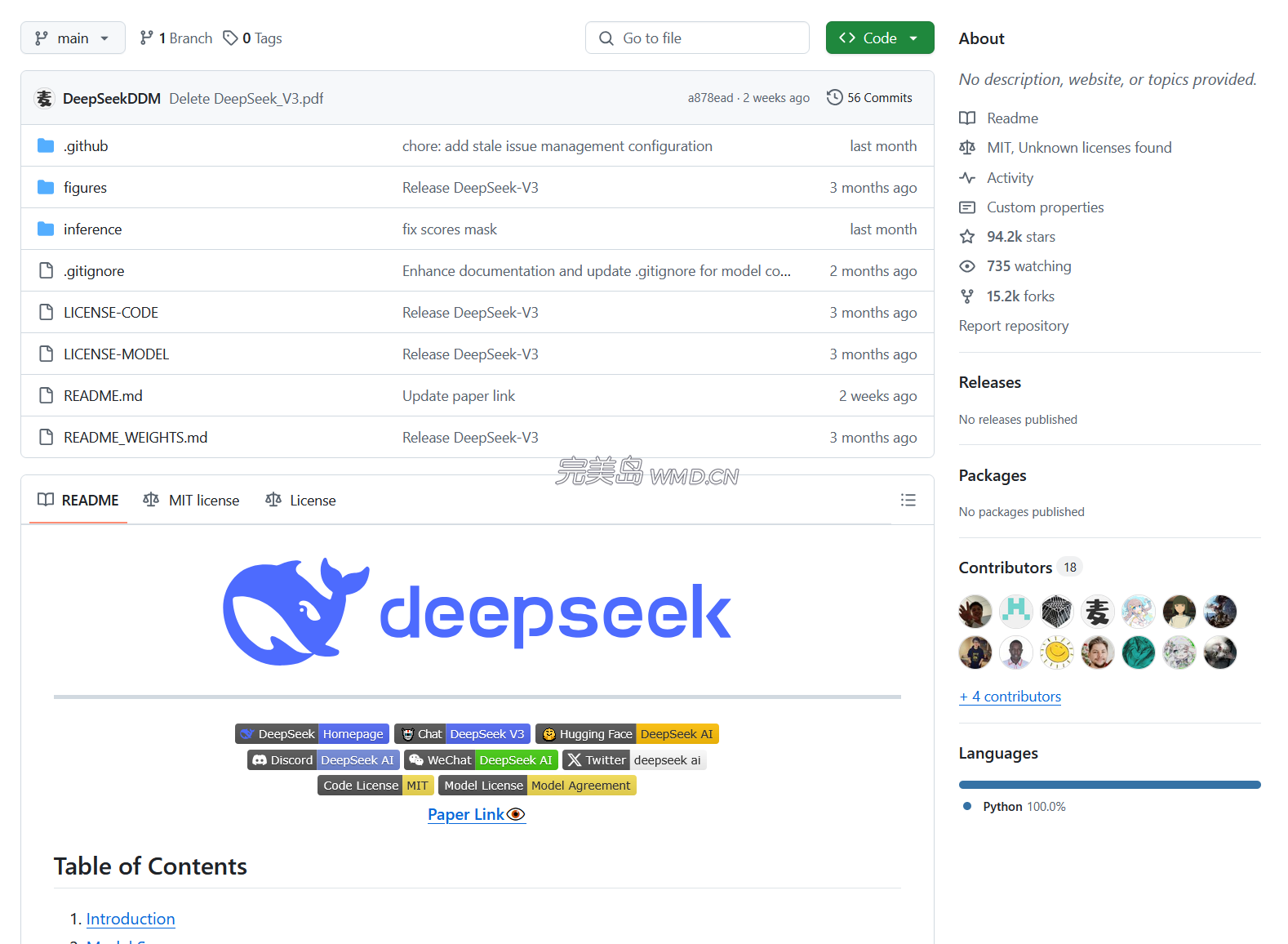

开发者:北京深度求索人工智能基础技术研究有限公司。

架构基础:采用Transformer架构,这是一种广泛应用于自然语言处理领域的架构,能够高效地处理长序列数据,并在并行计算方面具有优势。

版本迭代:有多个版本,如DeepSeek-V2、DeepSeek-V3等,不断进行优化和升级,性能持续提升。

技术特点

MoE架构:部分版本采用Mixture-of-Experts(MoE)架构,将模型划分为多个专家子模型,每个子模型负责处理不同的输入任务,能够更高效地利用计算资源,提高模型的泛化能力和鲁棒性1^。

Multi-Head Latent Attention(MLA)机制:在DeepSeek-V3中引入了该机制,通过压缩键和值为低秩潜在向量来降低内存占用,从而能够处理更长的序列,提高了处理长文本和复杂语言任务的效率和准确性1^。

Multi-Token Prediction(MTP)机制:在训练过程中预测多个未来的token来增强模型的文本生成能力,使模型在生成连贯、流畅和准确的文本方面表现出色,同时也提高了计算效率1^。

稀疏注意力机制:仅关注最相关的token来减少注意力计算的数量,降低计算开销,使模型在处理大规模数据集时更加高效和稳定,同时提高了泛化能力和鲁棒性1^。

训练与优化

训练数据集:包含大量高质量的文本数据,涵盖多种语言和领域,使模型能够学习到丰富的语言知识和上下文信息1^。

分词器:采用针对多语言压缩效率优化的分词器,进一步提高了模型的性能1^。

训练过程:包括预训练、长上下文扩展和后训练等阶段。预训练阶段学习语言的基本规律和结构;长上下文扩展阶段学习更复杂的上下文信息;后训练阶段通过监督学习和强化学习等任务进一步优化性能1^。

优化技术:采用FP8混合精度训练、DualPipe管道并行性和跨节点全对全通信内核等优化技术,提高训练效率,降低成本1^。

应用场景

智能对话与文本生成:能理解用户意图和需求,生成自然、流畅、准确的回复,可用于智能客服、智能助手、聊天机器人等领域1^。

语义理解与计算推理:可理解复杂语义关系和上下文信息,进行准确计算和推理,适用于知识问答、文本理解和语义搜索等场景1^。

代码生成补全:能理解代码语法和语义结构,根据用户输入生成高质量代码片段,助力编程辅助、代码自动化和智能开发1^。

多模态输入支持:除文本输入外,还支持图像、音频等多模态输入,能处理更复杂多样的任务,如图像描述生成、音频文本转换等1^。

性能表现

在目前大模型主流榜单中,DeepSeek-V3在开源模型中位列榜首,与世界上最先进的闭源模型不分伯仲2^。其推断速度快,吐字速度从v2的20TPS提升到60TPS2^。DeepSeek R1专注于推理能力,在数学、代码、自然语言推理等任务上性能可比肩OpenAI o1模型正式版2^。